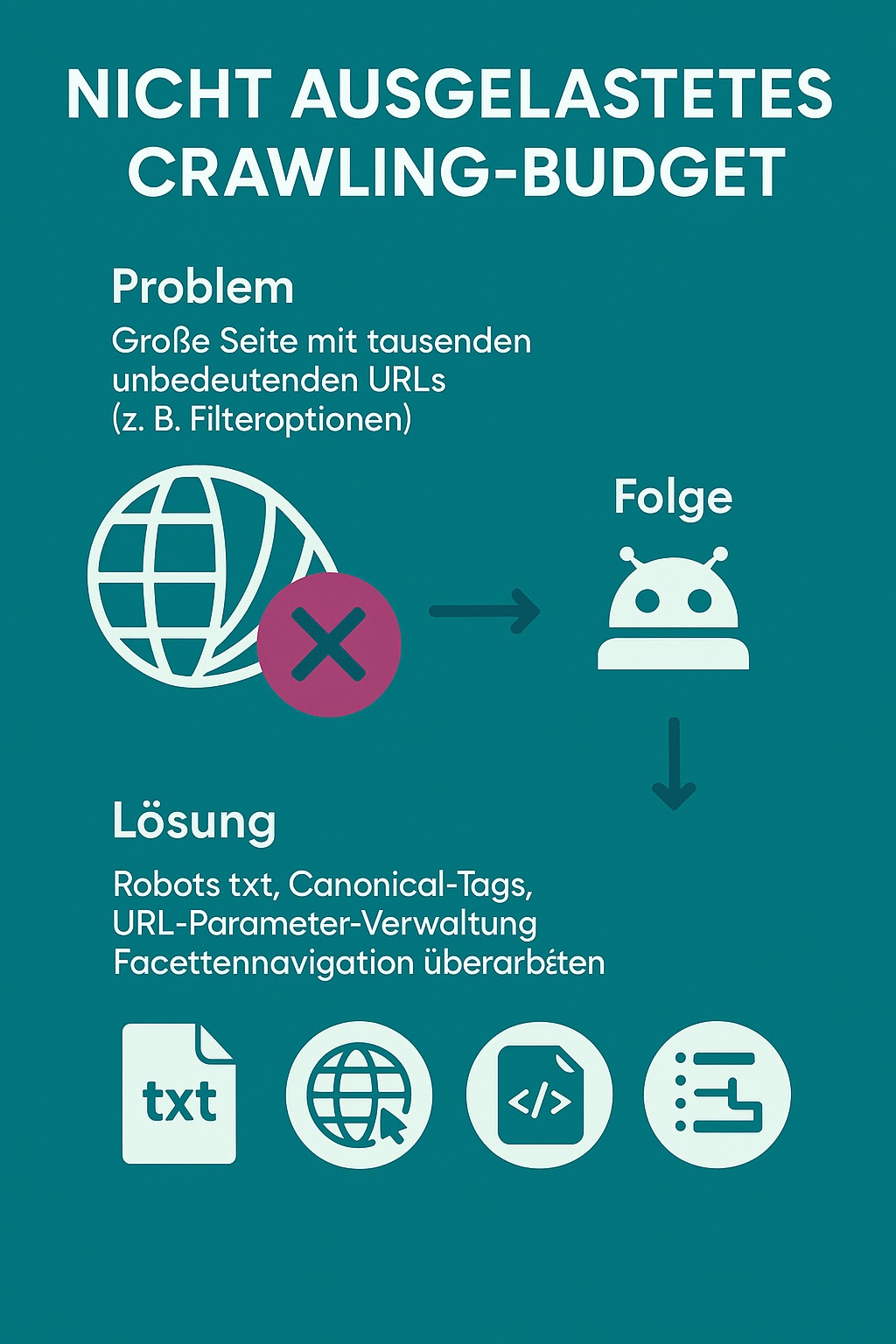

Je größer eine Website ist, desto wichtiger wird ein Thema, das viele unterschätzen: das Crawling-Budget. Es bestimmt, wie viele Seiten der Googlebot bei einem Besuch crawlt – und damit, welche Inhalte überhaupt in den Suchergebnissen auftauchen können.

Doch wenn große Websites tausende irrelevante URLs erzeugen, wird dieses Budget schnell verschwendet. Die Folge: Wichtige Inhalte werden nicht oder viel zu spät erfasst.

Was ist das Crawling-Budget?

Google hat pro Domain nur ein bestimmtes Kontingent an Ressourcen, das beim Crawling eingesetzt wird. Dieses Crawling-Budget setzt sich aus zwei Faktoren zusammen:

- Crawl Rate Limit – wie viele Anfragen der Googlebot Ihrem Server zumuten darf

- Crawl Demand – wie groß das Interesse von Google an Ihren Inhalten ist

Vor allem bei großen Seiten entscheidet die interne Linkstruktur, technische Umsetzung und URL-Vielfalt darüber, ob das Budget effizient genutzt wird – oder ob Google sich durch tausende überflüssige Seiten arbeiten muss.

Das Problem: Unzählige unwichtige URLs

Große Websites – etwa Online-Shops, Immobilienportale oder redaktionelle Plattformen – erzeugen oft automatisch eine riesige Anzahl von URLs. Häufige Ursachen sind:

- Filter- und Sortierfunktionen (z. B. Preis aufsteigend, Farbe blau, Größe M)

- Facettierte Navigationen mit vielen Kombinationsmöglichkeiten

- Session-IDs oder Tracking-Parameter in URLs

- Unbereinigte Kalenderfunktionen (z. B. bei Veranstaltungen oder Buchungen)

- Paginierung ohne klare Struktur

All diese URLs werden vom Googlebot als eigenständige Seiten behandelt – obwohl sie oft keinen Mehrwert bieten. Dadurch entstehen Crawling-Schleifen, die das Budget verschwenden.

Folge: Wichtige Inhalte bleiben auf der Strecke

Wenn Google sehr viel Zeit mit irrelevanten URLs verbringt, bleibt zu wenig Budget für die Inhalte, die eigentlich indexiert und gerankt werden sollen. Typische Auswirkungen:

- Neue Seiten werden erst sehr spät entdeckt

- Bestehende Inhalte werden zu selten aktualisiert

- Wichtige Kategorien oder Landingpages erhalten zu wenig Aufmerksamkeit

- Sichtbarkeit in Suchmaschinen sinkt langfristig

Besonders kritisch ist das bei saisonalen Inhalten, News oder SEO-Kampagnen – also dort, wo es auf Schnelligkeit und Aktualität ankommt.

Crawling gezielt steuern: So geht’s

Zum Glück gibt es eine Reihe bewährter Methoden, mit denen sich das Crawling-Budget effizienter einsetzen lässt. Ziel ist es, Google klar zu zeigen, welche Seiten wichtig sind – und welche ignoriert werden können.

Robots.txt gezielt einsetzen

In der robots.txt-Datei lassen sich ganze Verzeichnisse oder URL-Muster vom Crawling ausschließen. Das eignet sich z. B. für:

- Filter- oder Sortieroptionen (/filter/, ?sort=)

- Session-IDs (/session/)

- Kalenderseiten oder Archive

Wichtig: robots.txt verhindert nur das Crawling, nicht die Indexierung über externe Links. Deshalb ist sie ideal zur Crawling-Optimierung, aber keine Garantie gegen Sichtbarkeit.

Canonical-Tags korrekt setzen

Wenn mehrere URLs zum gleichen oder sehr ähnlichen Inhalt führen, sollten sie per rel=“canonical“ auf die Hauptseite verweisen. So erkennt Google:

- Diese Seite ist das Original.

- Andere Varianten müssen nicht gecrawlt oder indexiert werden.

Beispiel:

<link rel=“canonical“ href=https://www.beispielshop.de/hose-blau.html>

Für Seiten wie: https://www.beispielshop.de/hose-blau.html?size=M&sort=price

URL-Parameter in der Google Search Console verwalten

In der GSC können Sie unter „Alte Tools und Berichte“ > URL-Parameter angeben, welche Parameter keine inhaltliche Bedeutung haben (z. B. utm_source, ref, sort). So vermeiden Sie, dass Google diese Varianten crawlt.

Vorsicht: Diese Funktion sollte nur genutzt werden, wenn Sie genau wissen, wie Ihre Parameter funktionieren. Fehlerhafte Einstellungen können zum Ausschluss wichtiger Seiten führen.

Facettennavigation überarbeiten

Filter- und Facettennavigationen sind für Nutzer oft hilfreich – aus SEO-Sicht aber problematisch, wenn sie unkontrolliert URLs erzeugen. Besser:

- Filter per JavaScript oder POST-Methoden realisieren

- Nur SEO-relevante Kombinationen indexieren lassen

- Duplicate Content vermeiden (z. B. keine Filter für 3 Artikel-Seiten)

Besonders bei Shops ist hier oft großes Potenzial verborgen, das sich mit einem Relaunch oder technischer Anpassung nutzen lässt.

Crawling optimieren heißt Sichtbarkeit sichern

Gerade bei gewachsenen oder dynamisch erzeugten Seitenstrukturen lohnt sich ein kritischer Blick auf das Crawling-Verhalten – denn oft liegen hier ungenutzte Potenziale brach.

Sie möchten das Crawling Ihrer Website gezielt verbessern?

Ich freue mich auf Ihre Nachricht!