Was bedeutet Crawl-Delay eigentlich?

Wichtig zu wissen: Google beachtet den Parameter Crawl-delay in der robots.txt nicht mehr. Stattdessen verwendet der Googlebot eigene Signale, um die Crawling-Frequenz automatisch anzupassen – zum Beispiel die Serverreaktionszeit oder die interne Verlinkung der Inhalte. Trotzdem spricht man im SEO-Alltag oft vom „Crawl-Delay“, wenn das Crawlverhalten nicht zur Größe oder Struktur einer Seite passt.

Typische Probleme bei großen Websites

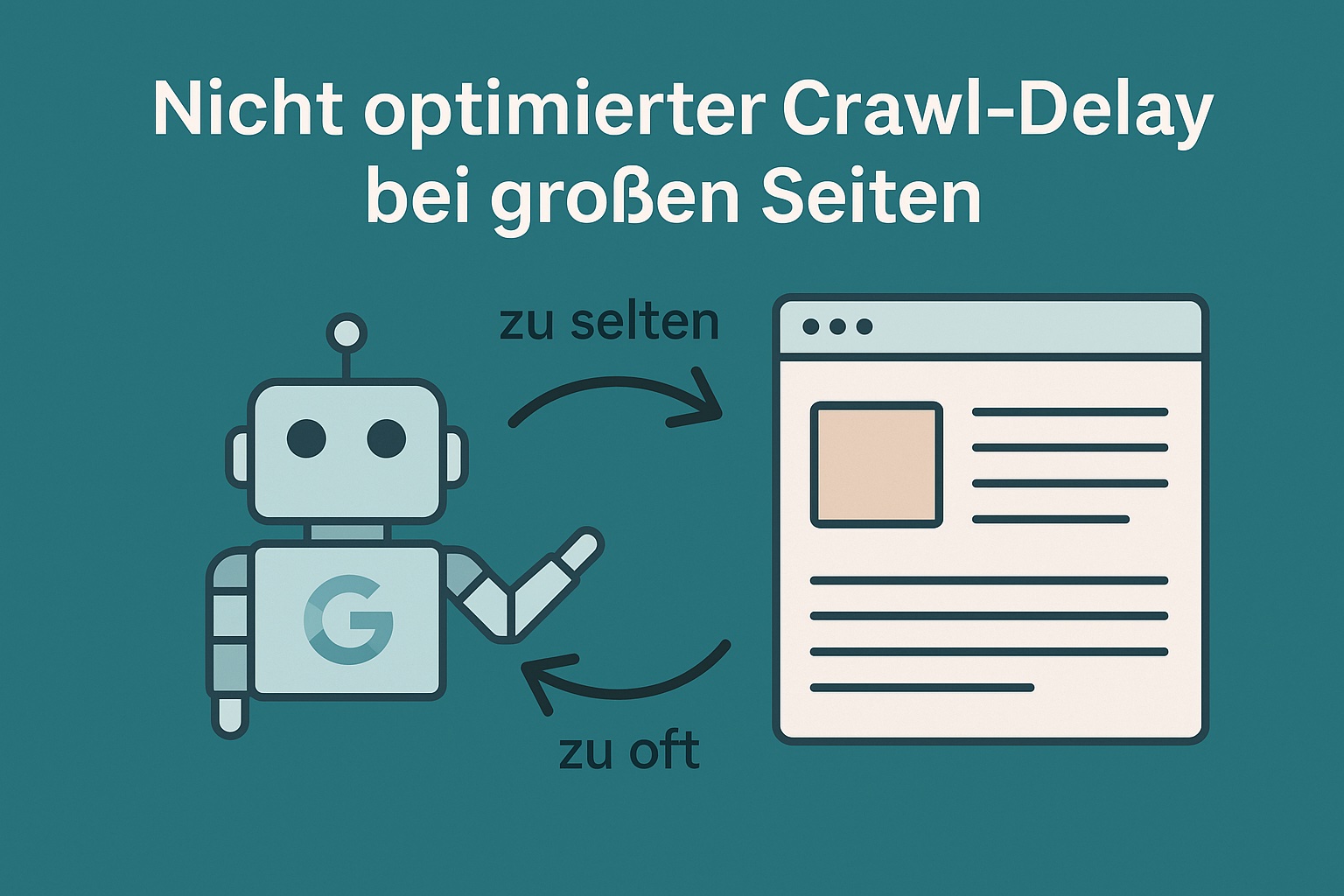

1. Zu seltener Crawl

Google crawlt nicht jede Seite gleich häufig. Bei sehr großen Websites kann es vorkommen, dass bestimmte Bereiche nur selten besucht werden. Neue Inhalte werden dadurch verspätet indexiert oder gar nicht erfasst. Auch Änderungen an bestehenden Seiten – etwa neue Texte oder strukturierte Daten – bleiben unter Umständen über Wochen hinweg unbemerkt.

Gerade bei saisonalen Angeboten, aktuellen Blogbeiträgen oder zeitkritischen Landingpages kann das zum echten Nachteil werden. Inhalte sind zwar online, aber in der Google-Suche noch nicht präsent – oder sie erscheinen mit veralteten Informationen.

2. Zu aggressiver Crawl

Umgekehrt kann es passieren, dass der Googlebot zu intensiv crawlt – besonders nach technischen Änderungen, neuen Sitemaps oder Relaunches. Das erhöht die Last auf dem Server, insbesondere bei schwächer konfigurierten Hostingpaketen. Im schlimmsten Fall kommt es zu einer spürbaren Verlangsamung oder sogar temporären Ausfällen der Website.

Google registriert solche Probleme – und kann die betroffene Website als instabil oder langsam einstufen. Die Folge: schlechtere Rankings, höhere Absprungraten, geringere Sichtbarkeit. Auch Nutzer:innen, die in diesen Momenten auf die Seite zugreifen wollen, bekommen ein negatives Nutzungserlebnis.

Ursachen eines unpassenden Crawl-Verhaltens

Oft liegt die Ursache nicht in einem einzelnen Fehler, sondern in der Summe kleinerer Schwächen:

- Die Website ist technisch komplex, z. B. mit vielen Parametern oder facettierten Navigationen.

- Es gibt viele irrelevante URLs, z. B. Filterseiten, PDFs oder doppelte Inhalte.

- Interne Verlinkungen sind nicht durchdacht – wichtige Seiten sind zu tief verschachtelt.

- Es werden keine aktuellen XML-Sitemaps bereitgestellt oder gepflegt.

- Die Serverperformance schwankt stark.

Wie lässt sich der Crawl sinnvoll steuern?

1. Serverlog-Analyse – Grundlage für alles

Nur mit Hilfe von Server-Logfiles lässt sich exakt feststellen, welche Seiten der Googlebot wie häufig besucht. Die Daten zeigen:

Wann wurde welche URL zuletzt gecrawlt?

Welche Pfade werden besonders häufig (oder gar nicht) besucht?

Wie verhält sich der Bot nach Änderungen an der Website?

Auf Basis dieser Informationen lassen sich gezielte Maßnahmen zur Crawl-Optimierung ableiten. Tools wie Screaming Frog Log File Analyser, Ryte oder SEOlyzer helfen bei der Auswertung.

2. Priorisierung über Sitemaps

Die XML-Sitemap ist für große Websites unverzichtbar. Sie dient als Steuerungselement für Google und zeigt, welche Seiten indexiert werden sollen – und welche nicht. Wichtig:

Die Sitemap sollte regelmäßig automatisch aktualisiert werden.

Nur relevante, indexierbare URLs sollten enthalten sein.

Bei sehr großen Seiten können mehrere Sitemaps (nach Bereich oder Kategorie) helfen, die Übersicht zu wahren.

In der Google Search Console lassen sich diese Sitemaps einreichen und überwachen. Dort ist auch sichtbar, wie viele der gemeldeten URLs tatsächlich im Index sind.

3. Optimierung der internen Verlinkung

Eine der wichtigsten Maßnahmen zur Crawl-Steuerung ist die interne Verlinkung. Seiten, die häufig intern verlinkt sind, gelten als wichtiger und werden entsprechend öfter gecrawlt. Folgende Tipps helfen:

Wichtige Inhalte prominent und mehrfach intern verlinken.

Veraltete oder unwichtige Seiten weniger stark verlinken.

Paginierungen und Filterseiten nicht zu tief in die Struktur einsinken lassen.

Navigationsstruktur regelmäßig überprüfen.

4. Ausschluss unwichtiger Inhalte

Nicht jede Seite muss gecrawlt werden. Unwichtige oder doppelte Inhalte können gezielt vom Crawl ausgeschlossen werden – zum Beispiel:

per robots.txt (Ausschluss vom Crawl)

per noindex (Ausschluss vom Index, bei weiter möglichem Crawl)

per Canonical-Tag (bei doppelten Inhalten)

So bleibt mehr Crawl-Budget für die wichtigen Seiten übrig.

5. Steuerung über die Google Search Console

In der GSC gibt es zwar keine direkte Einstellung mehr für den „Crawl-Delay“, aber über den Menüpunkt „Einstellungen > Crawling“ lassen sich Auffälligkeiten erkennen. Temporär lässt sich Google dort auch bitten, die Crawling-Intensität zu drosseln – etwa bei Serverproblemen oder nach einem Relaunch.

Über das Tool zur URL-Prüfung kann man zudem wichtige Seiten gezielt zur Indexierung einreichen. Das ersetzt keine strukturelle Steuerung, hilft aber bei akuten Problemen.

Crawl-Verhalten aktiv steuern lohnt sich

Sie möchten Ihr Crawl-Verhalten verbessern?

Gemeinsam schauen wir uns Ihre aktuelle Situation an und entwickeln eine nachhaltige Crawlstrategie – individuell und auf den Punkt.